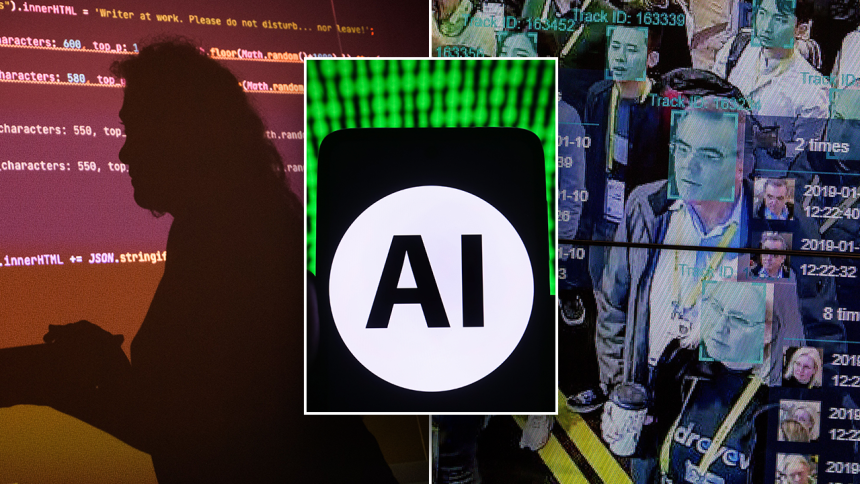

أدت ردود الفعل العنيفة ضد برنامج الدردشة الآلي Gemini للذكاء الاصطناعي (AI) من Google إلى زيادة المخاوف بشأن التحيز في نماذج اللغات الكبيرة (LLMs)، لكن الخبراء يحذرون من أن هذه المشكلات هي مجرد “قمة جبل الجليد” عندما يتعلق الأمر بالتأثير المحتمل لهذه التكنولوجيا عبر جميع أنحاء العالم. الصناعات.

أدى التقدم السريع في الذكاء الاصطناعي إلى تقدم كبير في مختلف المجالات. ويمكن أن يساعد في تحليل الصور الطبية مثل تصوير الثدي بالأشعة السينية والأشعة السينية، وتسريع تطوير علاجات دوائية جديدة، وتحسين استخدام الطاقة ومساعدة الشركات في اتخاذ قرارات مستنيرة بناءً على فرز كميات كبيرة من البيانات.

ومع ذلك، فإن اعتماد الحكومات والشركات للذكاء الاصطناعي لقدراته على حل المشكلات قوبل أيضًا بحذر كبير.

عدنان مسعود معترف به باعتباره المدير الإقليمي لشركة Microsoft وMVP (المحترف الأكثر قيمة) في مجال الذكاء الاصطناعي من قبل Microsoft. بصفته كبير المهندسين للذكاء الاصطناعي والتعلم الآلي في جامعة UST، فهو يتعاون مع مختبر ستانفورد للذكاء الاصطناعي، ومعهد ماساتشوستس للتكنولوجيا CSAIL، ويقود فريقًا من علماء البيانات والمهندسين الذين يبنون حلول الذكاء الاصطناعي.

GOOGLE GEMINI: موظف سابق وقادة تقنيون يقترحون الخطأ الذي حدث مع AI Chatbot

وقال لشبكة فوكس نيوز ديجيتال: “يعد الذكاء الاصطناعي حافزًا مذهلاً للتحول الرقمي. في كل مكان، بدءًا من إدارة الثروات إلى صحة السكان وحتى عمليات البيع بالتجزئة بدون لمس، تعمل تقنيات مثل التعلم الآلي ورؤية الكمبيوتر على جعل الخوارزميات سريعة ومحمولة ومنتشرة في كل مكان”.

لكنه سلط الضوء أيضًا على إمكانية حدوث جوانب سلبية كبيرة أيضًا. إن مطالبة الناس بتحديد التهديد الذي يرونه قادما من الذكاء الاصطناعي سوف يكسبنا مجموعة من الإجابات، من “الروبوتات تستولي على وظائفنا” إلى “الأخ الأكبر يراقبنا”. وفي حين يعترف مسعود بأن هذه كلها مخاوف معقولة، فإنه يعتقد أن التحدي الأكبر الذي تواجهه البشرية من الذكاء الاصطناعي يكمن في “قلب” خوارزمياته.

وقال لشبكة فوكس نيوز ديجيتال: “إن أنظمة الذكاء الاصطناعي لا يتم إنشاؤها من فراغ. فسلوكياتها تعكس أفضل الصفات البشرية، ولكنها تعكس أيضًا أسوأها”. “هذه النماذج متحيزة، والأمر متروك لنا لإصلاحها.”

ووفقا لمسعود، فإن التحيز الدائم هو أكبر تهديد يشكله الذكاء الاصطناعي ويمكن أن يكون له “تأثير مدمر” على الصحة وفرص العمل والوصول إلى المعلومات وحتى الديمقراطية.

والسؤال هو: ما الذي يستطيع المجتمع أن يفعله لتعديل البيانات التي تعكس ببساطة التحيزات المجتمعية المتأصلة؟ في الوقت الحالي، لا توجد لوائح حول المساءلة الخوارزمية. ويعتقد مسعود أن بعض المنظمات والحكومات تحرز تقدماً.

وقال: “مع تطور الذكاء الاصطناعي بهذه السرعة الهائلة، تتعزز التفاوتات المجتمعية المثيرة للمشاكل بالفعل حتى أثناء كتابتي. وإذا لم نتحرك بحذر، فإن هذه النماذج ستتسبب في أضرار لا يمكن إصلاحها”.

عضو مجلس الشيوخ عن ولاية أوهايو يطالب جوجل “بالانفصال” وسط كارثة الجوزاء: “واحدة من أخطر الشركات في العالم”

صرح فلافيو فيلانوستر، كبير مسؤولي أمن المعلومات العالمية في LexisNexis Risk Solutions، لـ Fox News Digital أن التأثير المحتمل لنماذج الذكاء الاصطناعي يمكن أن يتراوح من الاستجابات “غير المناسبة إلى حد ما” إلى النتائج التي يمكن أن تنتهك قوانين مكافحة التمييز الحالية. اعتمادًا على تطبيقه، يمكن أن يسبب الذكاء الاصطناعي مشكلات في عمليات التوظيف في الشركة ويتخذ قرارات خاطئة تتعلق بأهلية الحصول على مزايا الدولة، ومعدلات القروض، والقبول في الجامعات، وإمكانيات أخرى “لا حصر لها”.

وافق مسعود على أن الاستخدام الخاطئ للأتمتة لتبسيط عمل حكومة الولاية وعملية فحص التوظيف هو مثال بارز ولكن يومي على كيف يمكن لخوارزميات التعلم الآلي أن تؤدي إلى تفاقم التحيزات المنهجية.

في عام 2018، اكتشفت أمازون أن برنامج توظيف الذكاء الاصطناعي الخاص بها يميز ضد السير الذاتية التي تذكر النساء والمرشحين من الكليات المخصصة للنساء فقط. وكانت الخوارزمية تعتمد فقط في قراراتها على تاريخ الشركة المحدود في توظيف مهندسات وعلماء كمبيوتر. تم إلغاء البرنامج في وقت لاحق.

في نفس العام، وجدت الدراسات أن برنامج التعرف على الوجه الخاص بشركة Microsoft AI أعطى الذكور السود مشاعر سلبية أكثر من نظرائهم البيض.

وقال: “هذه الأمثلة هي مجرد قمة جبل الجليد عندما يتعلق الأمر بالطريقة التي يمكن بها للتكنولوجيا تضخيم القمع وتقويض المساواة”. “مع انتشار الذكاء الاصطناعي في كل مكان، تصبح الحالات أكبر من حيث الحجم، مما يمهد الطريق لمستقبل بائس لحكم الآلة.”

وأشار مسعود إلى أن هناك أيضًا حالات مثيرة للقلق من عنصرية الذكاء الاصطناعي المتأصلة في أنظمة العدالة، كما كان الحال عندما تم اكتشاف أن خوارزمية COMPAS قد مارست التمييز ضد الأشخاص الملونين.

التحيز العنصري في الذكاء الاصطناعي: اختبار برامج GOOGLE وMETA وChatGP وMicrosoft Chatbots

“إذا لم تكن هذه القضايا مثيرة للقلق بدرجة كافية، فقد بدأنا نشهد استخدامًا أكثر انتشارًا لهذه النماذج في التطبيقات الطبية للأغراض التشخيصية والعلاجية. وإذا قام النموذج، بسبب التحيز، بتقييم حالة المريض أو العلاج المناسب بشكل غير صحيح، وأضاف فيلانوستر: “قد يؤدي ذلك إلى عواقب تغير الحياة”.

اقترح كيرك سيجمون، المحامي المقيم في واشنطن العاصمة والمتخصص في الملكية الفكرية للذكاء الاصطناعي/التعلم الآلي، أن “جميع نماذج الذكاء الاصطناعي تقريبًا” متحيزة.

وأشار إلى أن الشبكات العصبية الاصطناعية يتم تدريبها على كميات هائلة من البيانات بناء على ما هو متاح. يتضمن ذلك نصوصًا من الكتب والصور من الإنترنت والمزيد. ونتيجة لذلك، مهما كانت القيود الموجودة في تلك البيانات تصبح “نقاط ضعف” في النموذج المدرب.

“إن أسلوب Google لإخفاء التحيز في نماذجها هو من خلال الهندسة السريعة السرية – أي تغيير طبيعة ما تطلب من النموذج القيام به عن طريق إضافة كلمات/محتوى إضافي (مثل متعدد الثقافات). ويبدو أيضًا أن هذا هو النهج الذي اتبعته Google قال: “OpenAI في منتج ChatGPT الخاص بهم. المشكلة هي أنهم لم يقوموا فعليًا بإصلاح التحيز الأساسي على الإطلاق: إنهم فقط يغيرون سرًا ما يطلبه المستخدمون لتجنب مشكلات العلاقات العامة، أو الترويج لأجندة معينة، أو ما شابه ذلك”. فوكس نيوز ديجيتال.

وقال سيجمون إن هذا غالبًا ما يؤدي إلى مخرجات أقل فائدة “إن لم تكن كوميدية تمامًا”، مما يثني المستخدمين عن استخدام الأداة. كانت شركة Gemini أحدث منظمة ذكاء اصطناعي تواجه ضغوطًا بسبب استجاباتها بعد أن أنتجت صورًا غير دقيقة تاريخيًا قللت من أهمية الأشخاص البيض أو أزالتهم تمامًا. أدى ذلك إلى اعتذارات علنية من Google وإيقاف ميزة إنشاء الصور مؤقتًا.

“إذا كان المجتمع يخطط للاعتماد بشكل متزايد على أدوات مثل ChatGPT وGemini، فإن الآثار المترتبة على الهندسة الفورية السرية يمكن أن تكون مخيفة. قد لا تكون لدينا مشكلة كبيرة مع نموذج الذكاء الاصطناعي الذي يحاول تجنب العنصرية الصريحة أو غير المقصودة، ولكن نفس الموجه السري وقال سيغمون: “قد يتم استخدام استراتيجيات التعديل لتغيير تصور الجمهور للأحداث التاريخية، أو دفن فضائح الشركات، أو ما شابه ذلك”.

الذكاء الاصطناعي أمر كبير، ولكن هل تقوم الشركات بالتوظيف لأدوار الذكاء الاصطناعي بسرعة كبيرة؟

وأضاف: “بعبارة أخرى، نفس الاستراتيجيات التي تستخدمها جوجل لضمان أن يكون الإنتاج متعدد الثقافات وغير مؤذي، يمكن استخدامها للتلاعب بالجمهور بطرق ضارة للغاية”.

صرح كريس روبي، الرئيس التنفيذي لمجموعة Ruby Media Group، والذي كشف مؤخرًا عن مجموعة كبيرة من البيانات حول Gemini، لـ Fox News Digital أن الذكاء الاصطناعي المتحيز يمكن أن يعيد إنشاء الأعراف والثقافات والقيم المجتمعية التي يمكن أن تجرد السياق التاريخي. إذا تمت إزالة الحقائق أو تغييرها، يمكن للشركة تنمية مجموعتها الخاصة من “الحقائق” التي تتوافق مع نظرتها الشخصية للعالم.

وشددت روبي، التي كتبت “ملفات روبي – القصة الحقيقية لرقابة الذكاء الاصطناعي”، على ضرورة محاسبة المسؤولين عن تشكيل بيئة المعلومات الحالية، لأن بنية منتجات الذكاء الاصطناعي يمكن أن تغير المشهد الرقمي المستقبلي الذي يعتمد عليه المجتمع في التعليم والتعلم. تجارة.

علاوة على ذلك، إذا كان علماء البيانات المسؤولون عن اتخاذ القرارات الحاسمة يفتقرون إلى التنوع السياسي، فسوف يُترك المستخدمون مع “منتج غير متوازن” “ينحرف إلى التحيز الجماعي لفريق المنتج”.

وأضافت: “الذكاء الاصطناعي يغير مجتمعنا”. “نظرًا لأننا أصبحنا أكثر اعتمادًا على البنية التحتية الرقمية الحديثة المضمنة في التعلم الآلي، يجب علينا أن نفهم أساس النماذج وكيفية بناء تلك النماذج. إن الدقة التاريخية لمجموعات البيانات الفردية المستخدمة لبناء منتج لا تقل أهمية عن الدقة التاريخية في العصر الحديث. “لا يمكننا أن نفهم إلى أين نحن ذاهبون إذا لم نفهم من أين أتينا.”

قالت سونيتا لونتوه، المديرة التنفيذية السابقة للتكنولوجيا الناشئة في Fortune 100، لقناة Fox News إن المجالس الرقمية وقادة الأعمال بحاجة إلى فهم أن تحيز الذكاء الاصطناعي موجود وقد أدى إلى تفاقم عدم المساواة على أساس الطبقة والعرق في تقييمات الرعاية الصحية والجدارة الائتمانية عبر خوارزميات الموافقة على الرهن العقاري في الماضي.

تزعم دعوى قضائية جماعية تم رفعها في ديسمبر أن شركة التأمين الصحي Human استخدمت نموذج الذكاء الاصطناعي nHPredict لحرمان الرعاية الصحية الضرورية طبيًا للمرضى المعاقين والمسنين المشمولين بموجب برنامج Medicare Advantage.

كيف يُحدث الذكاء الاصطناعي ثورة في عالم الطب

وقبل ذلك بشهر، زعمت دعوى قضائية أخرى أن شركة يونايتد هيلثكير استخدمت أيضًا نموذج nHPredict لرفض ادعاءات محددة على الرغم من علمها بأن الأداة كانت معيبة وتتناقض مع استنتاجات الأطباء.

“تتسلل التحيزات إلى الذكاء الاصطناعي لأن الخوارزمية تشبه الرأي. يمكن أن تدخل التحيزات طوال دورة حياة الذكاء الاصطناعي – بدءًا من تأطير المشكلة التي يحاول الذكاء الاصطناعي حلها، إلى تصميم المنتج وجمع البيانات، إلى التطوير والاختبار. وعلى هذا النحو، تتزايد المخاطر والنتائج وقالت لشبكة فوكس نيوز ديجيتال: “يجب أن تتم الضوابط في كل مرحلة من مراحل دورة حياة الذكاء الاصطناعي”.

وقال لونتوه، وهو عضو مجلس إدارة في العديد من الشركات المدرجة في بورصة نيويورك وناسداك، إن أعضاء مجلس الإدارة بحاجة إلى خطة لعبة لمراقبة وتأسيس حوكمة الذكاء الاصطناعي التي تتضمن التعاون مع خبراء داخليين وخارجيين.

يتناول منشور صادر عن المعهد الوطني للمعايير التكنولوجية (NIST) التحيز في الذكاء الاصطناعي. وفي الولايات المتحدة، يتطلب قانون المساءلة معالجة التحيز في خوارزميات الشركات. بموجب اللائحة العامة لحماية البيانات (GDPR)، قدم الاتحاد الأوروبي الحق في أن يتم إعلامه بمخرجات الخوارزمية. يركز إطار حوكمة نموذج الذكاء الاصطناعي في سنغافورة بشكل قوي على الحوكمة الداخلية وصنع القرار والنماذج وإدارة العمليات وإدارة علاقات العملاء.

وقال مسعود: “هناك العديد من الأمثلة المتباينة. لكن الخوارزميات تعمل عبر الحدود؛ ونحن بحاجة إلى قيادة عالمية في هذا الشأن. ومن خلال تزويد أصحاب المصلحة وصانعي السياسات بمنظور أوسع والأدوات الضرورية، يمكننا منع المتعصب في الآلة من إدامة تحيزه”. .

ومع ذلك، فهو لا يزال متفائلاً بأن البشرية يمكن أن تجعل الذكاء الاصطناعي يعمل لصالحها.

اقرأ المزيد من فوكس بيزنس