النسخة الأصلية ل هذه القصة ظهرت في مجلة كوانتا.

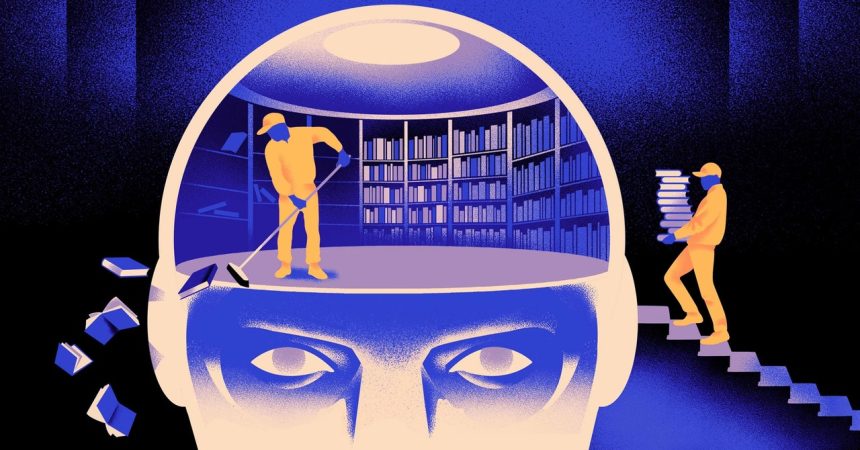

ابتكر فريق من علماء الكمبيوتر نموذجًا أكثر ذكاءً ومرونة من نموذج التعلم الآلي. الحيلة: يجب أن تنسى بشكل دوري ما تعرفه. وعلى الرغم من أن هذا النهج الجديد لن يحل محل النماذج الضخمة التي تقوم عليها أكبر التطبيقات، إلا أنه يمكن أن يكشف المزيد عن كيفية فهم هذه البرامج للغة.

وقال جيا كوون، مهندس الذكاء الاصطناعي في معهد العلوم الأساسية في كوريا الجنوبية، إن البحث الجديد يمثل “تقدمًا كبيرًا في هذا المجال”.

يتم تشغيل محركات لغة الذكاء الاصطناعي المستخدمة اليوم في الغالب بواسطة شبكات عصبية اصطناعية. كل “خلية عصبية” في الشبكة هي وظيفة رياضية تستقبل إشارات من خلايا عصبية أخرى، وتجري بعض الحسابات، وترسل إشارات عبر طبقات متعددة من الخلايا العصبية. في البداية يكون تدفق المعلومات عشوائيًا إلى حد ما، ولكن من خلال التدريب، يتحسن تدفق المعلومات بين الخلايا العصبية حيث تتكيف الشبكة مع بيانات التدريب. إذا أراد أحد باحثي الذكاء الاصطناعي إنشاء نموذج ثنائي اللغة، على سبيل المثال، فسوف يقوم بتدريب النموذج باستخدام كومة كبيرة من النص من كلتا اللغتين، مما سيؤدي إلى ضبط الاتصالات بين الخلايا العصبية بطريقة تربط النص في لغة واحدة بما يعادله. الكلمات في الآخر.

لكن عملية التدريب هذه تتطلب الكثير من القوة الحاسوبية. إذا لم يعمل النموذج بشكل جيد، أو إذا تغيرت احتياجات المستخدم لاحقًا، فمن الصعب تعديله. قال ميكيل أرتيتكس، المؤلف المشارك في البحث الجديد ومؤسس شركة Reka الناشئة في مجال الذكاء الاصطناعي: “لنفترض أن لديك نموذجًا يحتوي على 100 لغة، ولكن تخيل أن لغة واحدة تريدها لم تتم تغطيتها”. “يمكنك البدء من جديد من الصفر، لكن هذا ليس مثاليًا.”

وقد حاول أرتيتكس وزملاؤه التحايل على هذه القيود. قبل بضع سنوات، قام أرتيتكس وآخرون بتدريب شبكة عصبية على لغة واحدة، ثم قاموا بمحو ما كانت تعرفه عن الوحدات الأساسية للكلمات، والتي تسمى الرموز. يتم تخزينها في الطبقة الأولى من الشبكة العصبية، والتي تسمى طبقة التضمين. لقد تركوا جميع الطبقات الأخرى من النموذج وحدها. وبعد محو الرموز المميزة للغة الأولى، أعادوا تدريب النموذج على اللغة الثانية، مما ملأ طبقة التضمين برموز جديدة من تلك اللغة.

على الرغم من أن النموذج يحتوي على معلومات غير متطابقة، إلا أن إعادة التدريب نجحت: حيث تمكن النموذج من تعلم اللغة الجديدة ومعالجتها. وتوقع الباحثون أنه في حين أن طبقة التضمين تخزن معلومات خاصة بالكلمات المستخدمة في اللغة، فإن المستويات الأعمق للشبكة تخزن معلومات أكثر تجريدًا حول المفاهيم الكامنة وراء اللغات البشرية، مما ساعد النموذج على تعلم اللغة الثانية.

“نحن نعيش في نفس العالم. قال ييهونغ تشين، المؤلف الرئيسي للدراسة الأخيرة: “إننا نتصور نفس الأشياء بكلمات مختلفة بلغات مختلفة”. “لهذا السبب لديك نفس المنطق عالي المستوى في النموذج. “التفاحة شيء حلو وعصير، وليست مجرد كلمة.”