النسخة الأصلية من هذه القصة ظهرت في مجلة Quanta.

نماذج اللغة الكبيرة تعمل بشكل جيد لأنها كبيرة جدًا. تستخدم أحدث النماذج من Openai و Meta و Deepseek مئات المليارات من “المعلمات” – المقابض القابلة للتعديل التي تحدد الاتصالات بين البيانات وتحصل على تعديل أثناء عملية التدريب. مع المزيد من المعلمات ، تكون النماذج أكثر قدرة على تحديد الأنماط والاتصالات ، مما يجعلها بدورها أكثر قوة ودقة.

لكن هذه القوة تأتي بتكلفة. تدريب نموذج مع مئات المليارات من المعلمات يأخذ موارد حسابية ضخمة. لتدريب طراز Gemini 1.0 Ultra ، على سبيل المثال ، قيل إن Google أنفقت 191 مليون دولار. تتطلب نماذج اللغة الكبيرة (LLMS) أيضًا قوة حسابية كبيرة في كل مرة يجيبون فيها على طلب ، مما يجعلها خنازير الطاقة سيئة السمعة. يستهلك استعلام واحد لـ ChatGPT حوالي 10 أضعاف الطاقة مثل بحث Google واحد ، وفقًا لمعهد أبحاث الطاقة الكهربائية.

رداً على ذلك ، يفكر بعض الباحثين الآن. أصدرت IBM و Google و Microsoft و Openai جميع طرز اللغة الصغيرة (SLMs) التي تستخدم بضعة مليارات من المعلمات – جزء من نظرائهم LLM.

لا يتم استخدام النماذج الصغيرة كأدوات للأغراض العامة مثل أبناء عمومتها الأكبر. لكن يمكنهم التفوق على مهام محددة وأكثر ضيقة ، مثل تلخيص المحادثات ، والإجابة على أسئلة المريض باعتبارها chatbot للرعاية الصحية ، وجمع البيانات في الأجهزة الذكية. وقال زيكو كولتر ، عالم الكمبيوتر بجامعة كارنيجي ميلون: “بالنسبة للعديد من المهام ، فإن نموذج المليار البالغ 8 مليارات من المعايير هو في الواقع جيد للغاية”. يمكنهم أيضًا تشغيل جهاز كمبيوتر محمول أو هاتف محمول ، بدلاً من مركز بيانات ضخم. (لا يوجد إجماع على التعريف الدقيق لـ “Small” ، ولكن النماذج الجديدة جميعها تصل إلى حوالي 10 مليارات من المعلمات.)

لتحسين عملية التدريب لهذه النماذج الصغيرة ، يستخدم الباحثون بعض الحيل. غالبًا ما تتخلص النماذج الكبيرة من بيانات التدريب الخام من الإنترنت ، ويمكن أن تكون هذه البيانات غير منظمة وفوضوية ويصعب معالجتها. لكن هذه النماذج الكبيرة يمكنها إنشاء مجموعة بيانات عالية الجودة يمكن استخدامها لتدريب نموذج صغير. يحصل النهج ، الذي يسمى تقطير المعرفة ، على النموذج الأكبر لتمرير تدريبه بشكل فعال ، مثل المعلم الذي يقدم دروسًا للطالب. وقال كولتر: “السبب في (SLMS) يفيد مع مثل هذه النماذج الصغيرة ومثل هذه البيانات الصغيرة هو أنها تستخدم بيانات عالية الجودة بدلاً من الأشياء الفوضوية”.

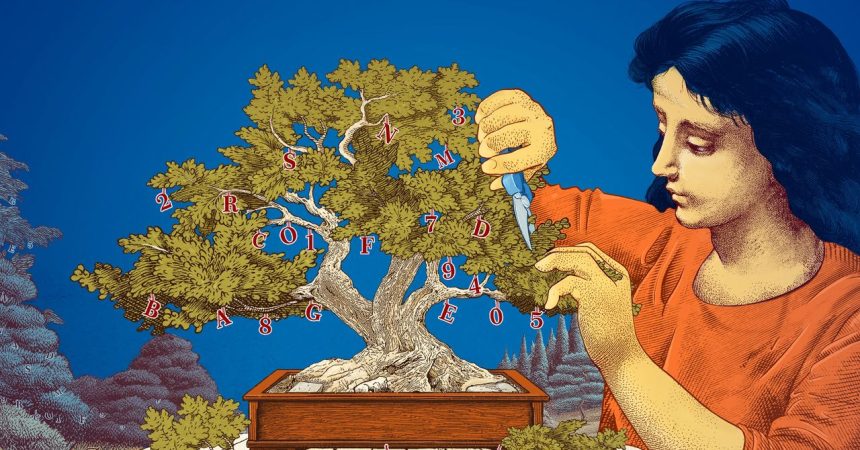

لقد استكشف الباحثون أيضًا طرقًا لإنشاء نماذج صغيرة من خلال البدء بأعداد كبيرة وتقطيعها. تستلزم إحدى الطرق ، المعروفة باسم التقليم ، إزالة أجزاء غير ضرورية أو غير فعالة من شبكة عصبية – شبكة المترامية الأطراف لنقاط البيانات المتصلة التي تكمن وراء نموذج كبير.

استلهم التقليم من شبكة عصبية واقعية ، الدماغ البشري ، الذي يكتسب الكفاءة عن طريق قص الوصلات بين المشابك كشخص. تعود نهج التقليم اليوم إلى ورقة عام 1989 حيث جادل عالم الكمبيوتر يان ليكون ، الآن في ميتا ، أنه يمكن إزالة ما يصل إلى 90 في المائة من المعلمات في شبكة عصبية مدربة دون التضحية بالكفاءة. ودعا طريقة “تلف الدماغ الأمثل”. يمكن أن يساعد التقليم للباحثين في ضبط نموذج لغة صغير لمهمة أو بيئة معينة.

بالنسبة للباحثين المهتمين بكيفية قيام نماذج اللغة بالأشياء التي تقوم بها ، تقدم النماذج الأصغر طريقة غير مكلفة لاختبار الأفكار الجديدة. ولأن لديهم معلمات أقل من النماذج الكبيرة ، فقد يكون تفكيرهم أكثر شفافية. وقال ليشم تشوشين ، عالم الأبحاث في مختبر MIT-IBM Watson AI Lab: “إذا كنت ترغب في إنشاء نموذج جديد ، فأنت بحاجة إلى تجربة الأشياء”. “تسمح النماذج الصغيرة للباحثين بتجربة المخاطر المنخفضة.”

ستبقى النماذج الكبيرة باهظة الثمن ، مع معلماتها المتزايدة باستمرار ، مفيدة للتطبيقات مثل chatbots المعممة ومولدات الصور واكتشاف المخدرات. ولكن بالنسبة للعديد من المستخدمين ، سيعمل نموذج صغير مستهدف أيضًا ، في حين أن الباحثين يسهلون تدريبهم والبناء. وقال تشوشين: “يمكن لهذه النماذج الفعالة توفير المال والوقت والحساب”.

القصة الأصلية أعيد طبعه بإذن من مجلة Quanta ، منشور مستقل تحريري ل مؤسسة سيمونز تتمثل مهمتها في تعزيز الفهم العام للعلوم من خلال تغطية التطورات البحثية والاتجاهات في الرياضيات والعلوم المادية والحياة.